クレードコードを使用した長時間のタスクにおいて、Kimi-K2-Thinkingがどのように安定を保つか

OneRouterはClaude Codeをサポートしています

By アンドリュー・ジェン •

OneRouterはClaude Codeをサポートしています

2025/12/15

アンドリュー・ジェン

開発者や研究者は、今日、大規模言語モデルを選択する際に三つの主要な課題に直面しています: 長期的な推論の維持、コンテキスト制限の管理、および運用コストの制御です。Claude Sonnet 4やGPT-5のような従来の閉じたモデルは、強力なパフォーマンスを提供しますが、複数のステップやツールベースのワークフローを扱う際にコストがかさみ、制約を受けます。

この記事では、ステップバイステップの推論、ダイナミックなツール統合、大容量のコンテキストを組み合わせたオープンでエージェント指向の代替手段であるKimi-K2-Thinkingを紹介します。比較、ベンチマーク、セットアップガイドを通じて、Kimi-K2が複雑なAIタスクにおける整合性、スケール、手頃な価格の苦痛をどのように解決するかを説明します。

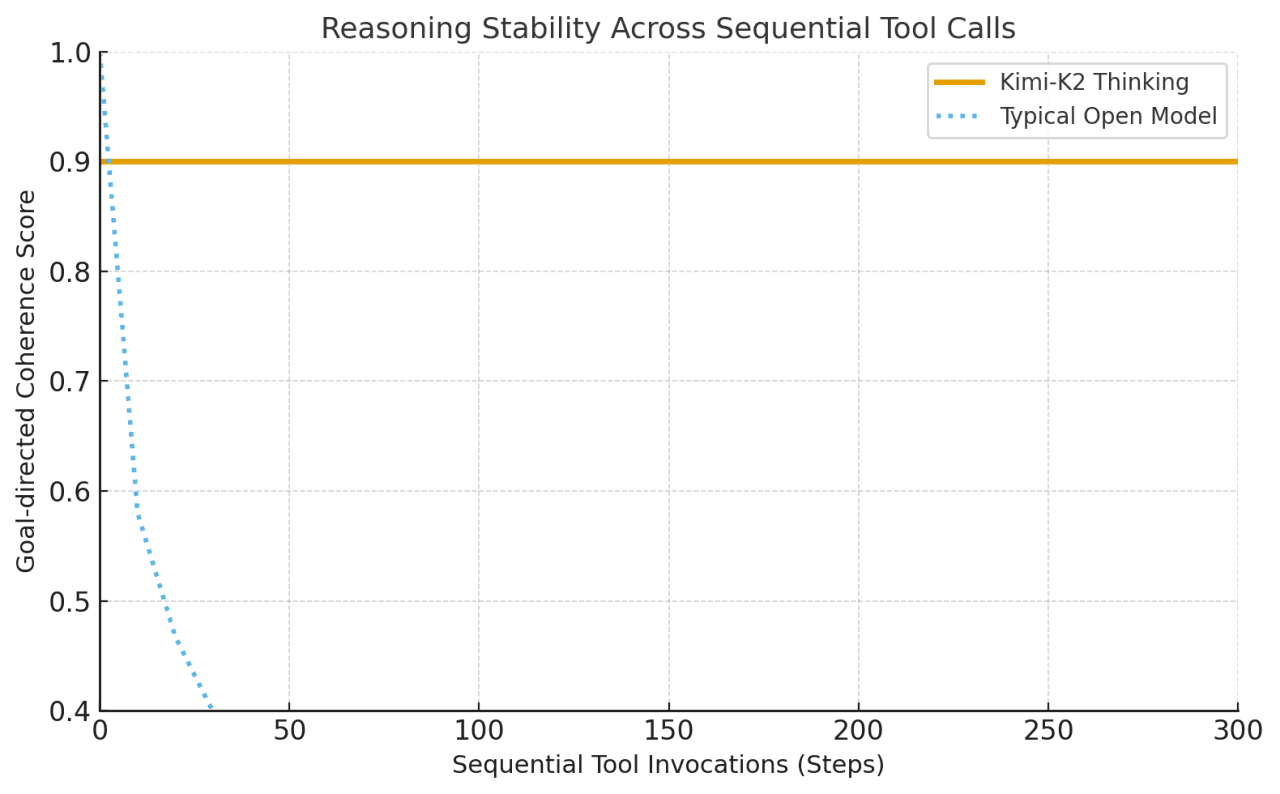

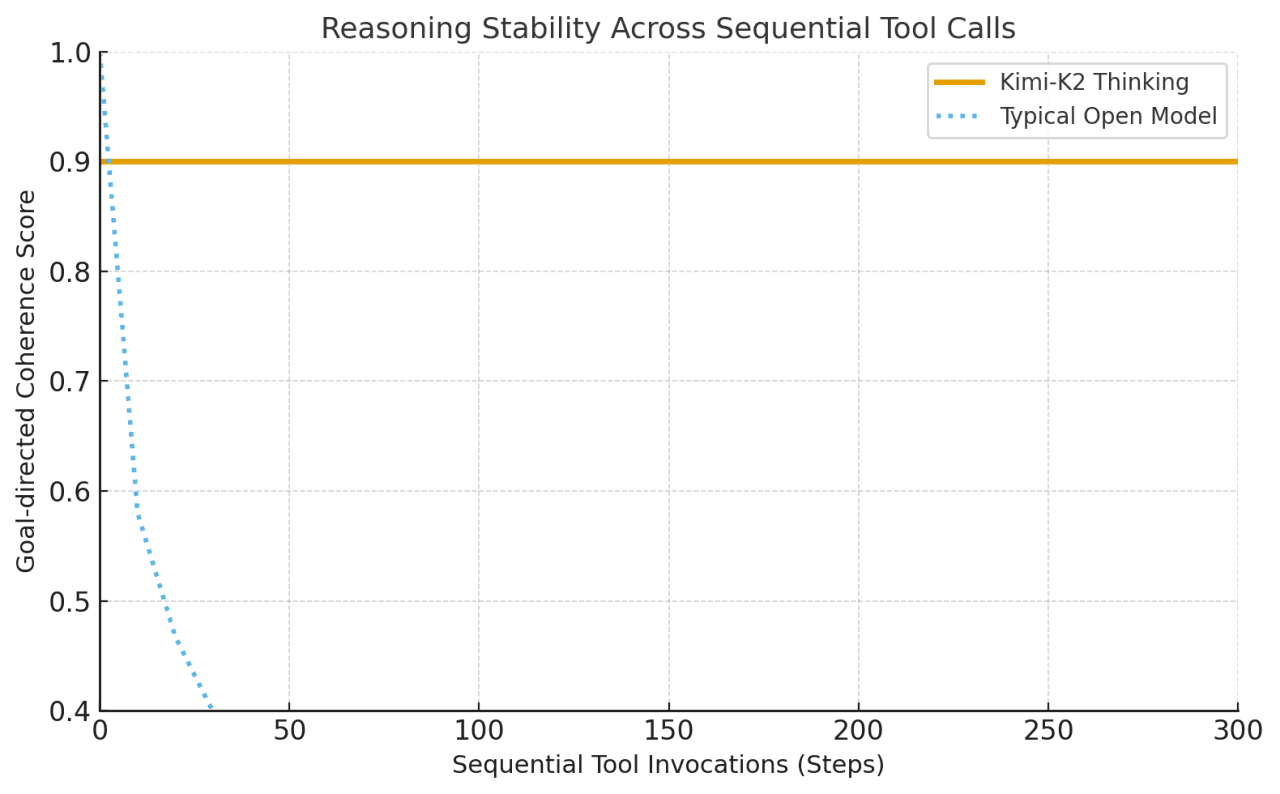

Kimi-K2 Thinkingは、ステップバイステップのChain-of-Thought推論をダイナミックな関数/ツール呼び出しと交互に行う「思考エージェント」として構築されました。通常のモデルが数回のツール使用後に漂ったり整合性を失ったりするのに対し、Kimi-K2は人間の介入なしで200〜300の連続したツール呼び出しにわたって安定した目標指向の行動を維持します。

これは大きな飛躍です: 以前のオープンモデルは、30〜50ステップ後に劣化する傾向がありました。言い換えれば、Kimi-K2は複雑な問題を解決するために、1セッションで何百もの実行ステップを処理できます。

AnthropicのClaudeは、そのような「交互思考」をツールで知られていましたが、Kimi-K2はこの機能をオープンソースの領域にもたらします。

このアーキテクチャは、スケール、効率、安定性のバランスを取り、Kimi-K2-Thinkingが長いシーケンスにわたって複雑でツールが豊富な推論を維持できるようにします。

アーキテクチャ特徴 | 実用的な利点 |

|---|---|

専門家の混合 (MoE) | コストを上げることなくモデルの能力を拡張し、各タスクに最も関連性の高い専門家を選択します。 |

1Tパラメータ / 32Bアクティブ | 大規模な知識と効率的な計算を組み合わせます。 |

61層と1つの密な層 | ステップ間で深く一貫した推論を維持します。 |

384の専門家、トークンごとに8つがアクティブ | 多様な問題に対する専門性と適応性を向上させます。 |

256Kコンテキスト長 | 非常に長い入力を処理し、長い推論チェーンでの連続性を維持します。 |

MLA (マルチヘッド潜在注意) | 長距離の焦点を強化し、メモリ負荷を軽減します。 |

SwiGLU活性化 | トレーニングを安定させ、滑らかで正確な推論をサポートします。 |

Kimi-K2は、主要な数学ベンチマークでGPT-5やClaudeに近いパフォーマンスを発揮しますが、MMLU-Pro/Redux、Longform WritingおよびCodeではGPT-5やClaudeにわずかに遅れを取っています。

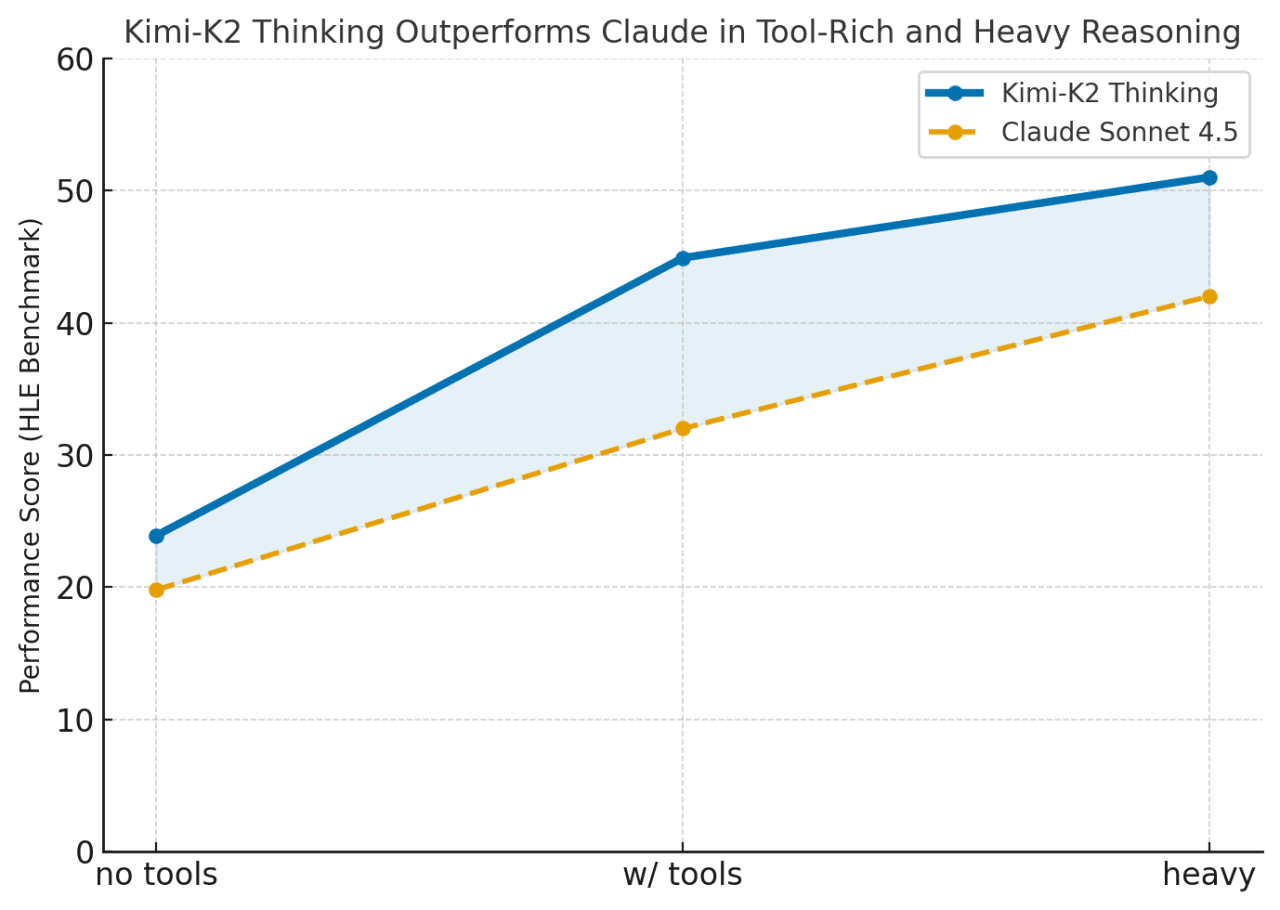

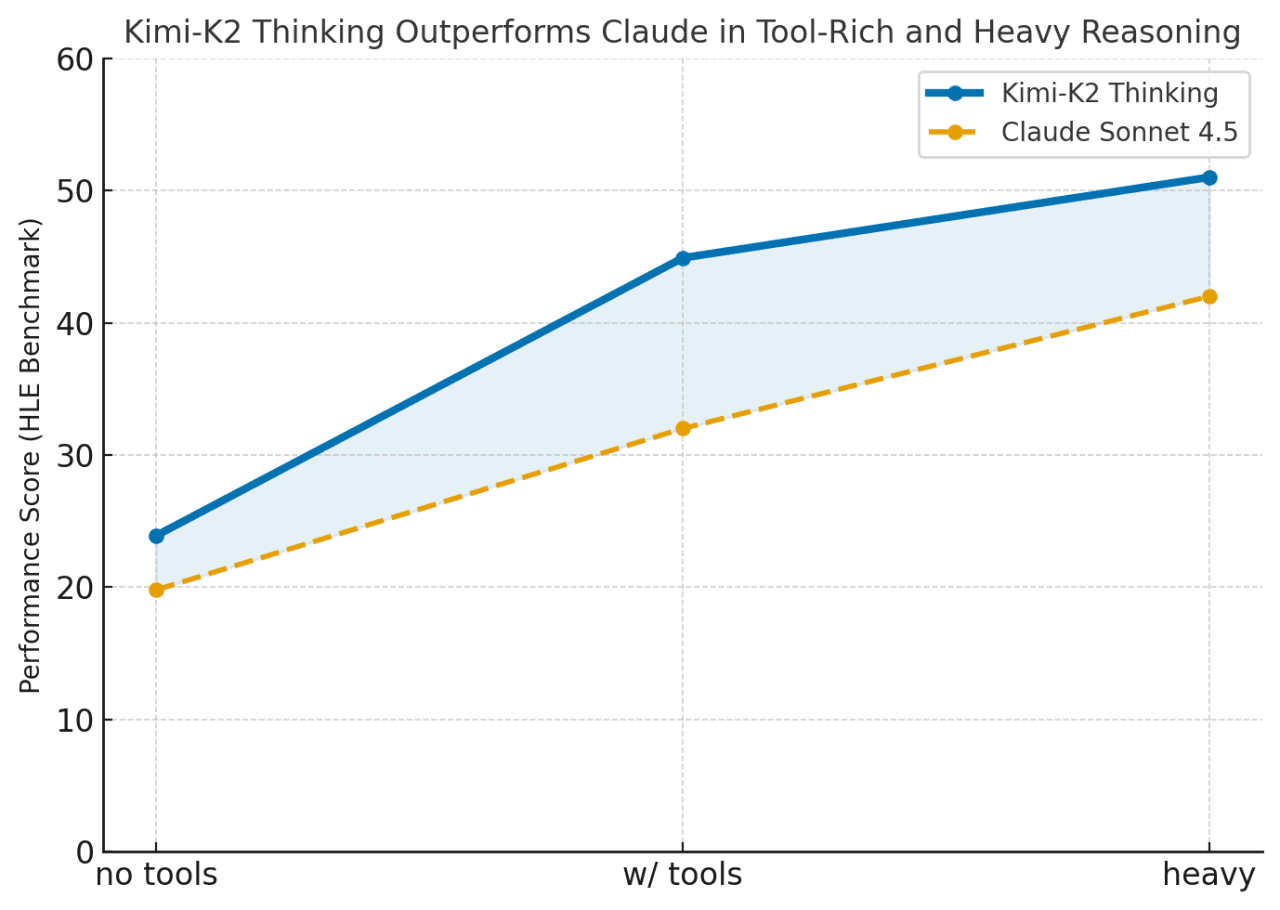

Kimi-K2は、ツールが有効になっている場合や、タスクが長い連鎖的推論を必要とする場合に優れた性能を発揮します (HLE w/ tools = 44.9 vs Claude 32.0)。Kimi-K2は、Claudeのような閉じたモデルとオープンソースシステムの間のギャップを埋め、持続的でツールが豊富な問題解決に優れています。

カテゴリ | ベンチマーク | 設定 | Kimi K2 Thinking | GPT-5 (高) | Claude Sonnet 4.5 (Thinking) | Kimi K2 0905 | DeepSeek-V3.2 | Grok-4 |

|---|---|---|---|---|---|---|---|---|

推論 / 数学 | HLE | ツールなし | 23.9 | 26.3 | 19.8 | 7.9 | 19.8 | 25.4 |

HLE | ツールあり | 44.9 | 41.7 | 32.0 | 21.7 | 20.3 | 41.0 | |

HLE | 重い | 51.0 | 42.0 | – | – | – | 50.7 | |

AIME25 | ツールなし | 94.5 | 94.6 | 87.0 | 51.0 | 89.3 | 91.7 | |

AIME25 | Pythonあり | 99.1 | 99.6 | 100.0 | 75.2 | 58.1 | 98.8 | |

AIME25 | 重い | 100.0 | 100.0 | – | – | – | 100.0 | |

HMMT25 | ツールなし | 89.4 | 93.3 | 74.6 | 38.8 | 83.6 | 90.0 | |

HMMT25 | Pythonあり | 95.1 | 96.7 | 88.8 | 70.4 | 49.5 | 93.9 | |

HMMT25 | 重い | 97.5 | 100.0 | – | – | – | 96.7 | |

IMO-AnswerBench | ツールなし | 78.6 | 76.0 | 65.9 | 45.8 | 76.0 | 73.1 | |

GPQA | ツールなし | 84.5 | 85.7 | 83.4 | 74.2 | 79.9 | 87.5 | |

一般タスク | MMLU-Pro | ツールなし | 84.6 | 87.1 | 87.5 | 81.9 | 85.0 | – |

MMLU-Redux | ツールなし | 94.4 | 95.3 | 95.6 | 92.7 | 93.7 | – | |

Longform Writing | ツールなし | 73.8 | 71.4 | 79.8 | 62.8 | 72.5 | – | |

HealthBench | ツールなし | 58.0 | 67.2 | 44.2 | 43.8 | 46.9 | – | |

エージェント検索 | BrowseComp | ツールあり | 60.2 | 54.9 | 24.1 | 7.4 | 40.1 | – |

BrowseComp-ZH | ツールあり | 62.3 | 63.0 | 42.4 | 22.2 | 47.9 | – | |

Seal-0 | ツールあり | 56.3 | 51.4 | 53.4 | 25.2 | 38.5 | – | |

FinSearchComp-T3 | ツールあり | 47.4 | 48.5 | 44.0 | 10.4 | 27.0 | – | |

Frames | ツールあり | 87.0 | 86.0 | 85.0 | 58.1 | 80.2 | – | |

コーディングタスク | SWE-bench Verified | ツールあり | 71.3 | 74.9 | 77.2 | 69.2 | 67.8 | – |

SWE-bench Multilingual | ツールあり | 61.1 | 55.3 | 68.0 | 55.9 | 57.9 | – | |

Multi-SWE-bench | ツールあり | 41.9 | 39.3 | 44.3 | 33.5 | 30.6 | – | |

SciCode | ツールなし | 44.8 | 42.9 | 44.7 | 30.7 | 37.7 | – | |

LiveCodeBench V6 | ツールなし | 83.1 | 87.0 | 64.0 | 56.1 | 74.1 | – | |

OJ-Bench (cpp) | ツールなし | 48.7 | 56.2 | 30.4 | 25.5 | 38.2 | – | |

Terminal-Bench | シミュレーションツール (JSON) 利用 | 47.1 | 43.8 | 51.0 | 44.5 | – | – |

ツールなし: 純粋な言語推論、外部ツールなし。

ツールあり: 外部ツール (例: 検索、コード) を呼び出すことができます。

Pythonあり: 計算にはPythonのみを使用します。

シミュレーションツール (JSON) 利用: JSON形式でのツール呼び出しをシミュレートします。

重い: 高強度の長鎖推論テスト。

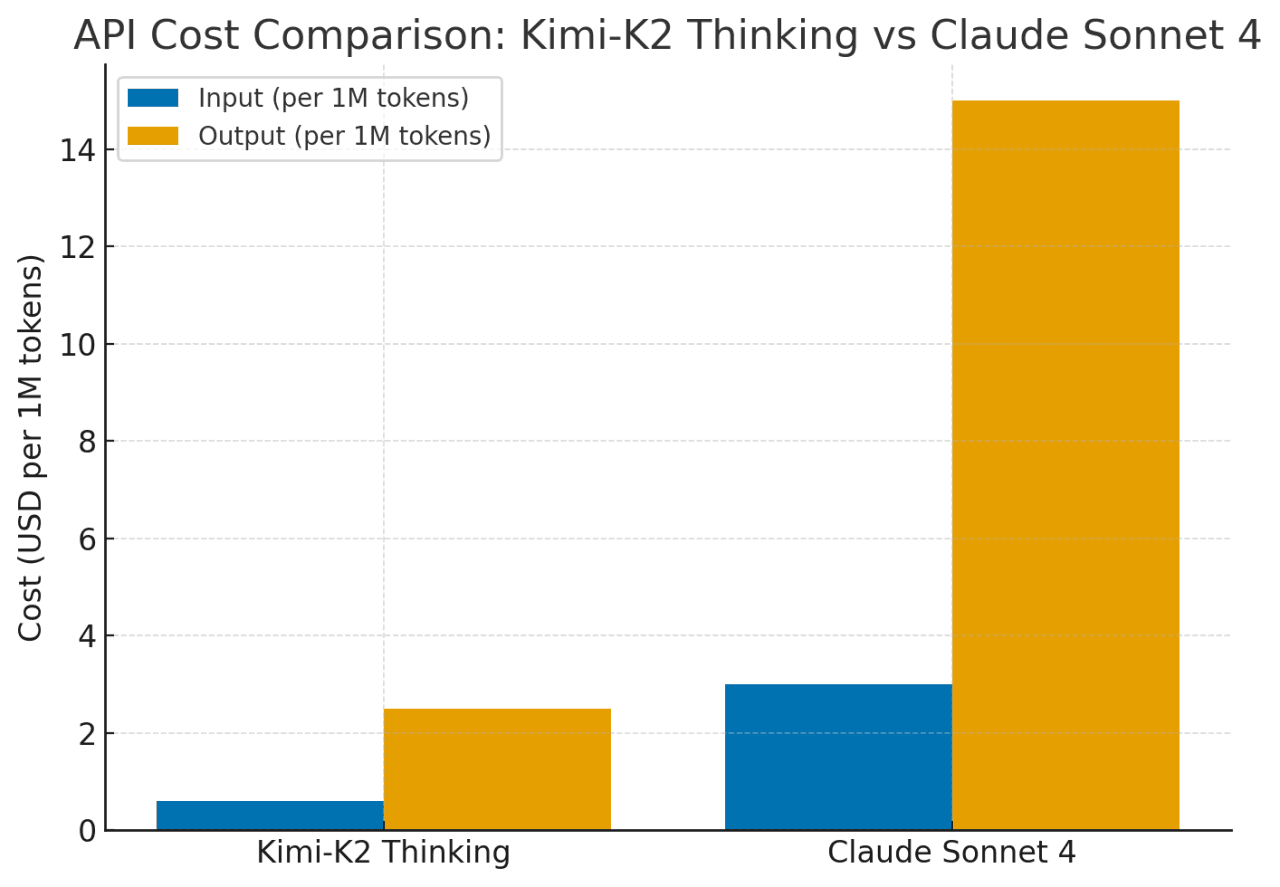

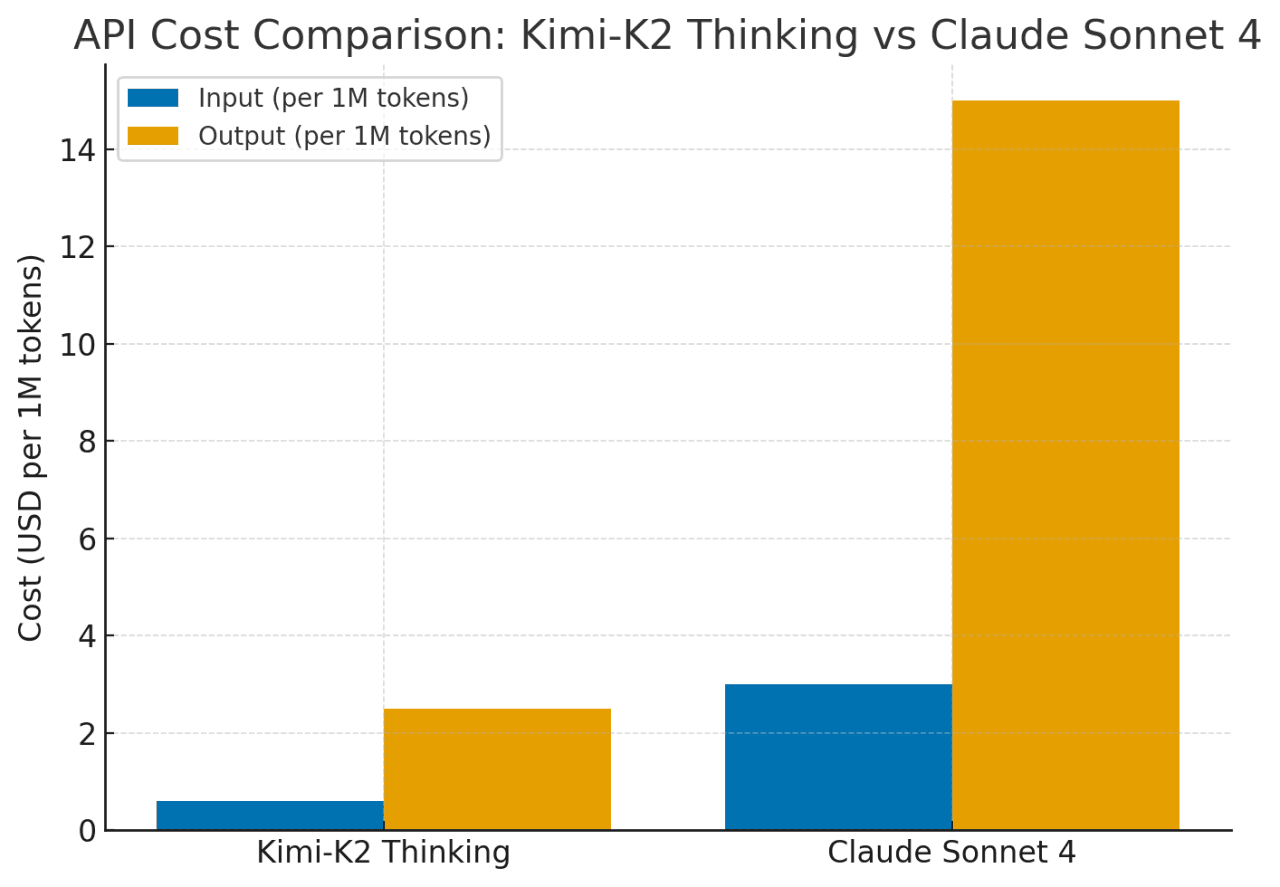

Kimi-K2は、Claude Sonnet 4に対し、約75〜80%低コストで類似の機能を提供します。その価格設定は、長いコンテキスト (最大256Kトークン) や頻繁なツール使用に対しても平坦で、Claudeのコストは長いコンテキストやエージェントアクションに対して急激に上昇します。要するに、Kimi-K2は、複雑で長期的な推論タスクにおいて、Claude/GPTレベルのパフォーマンスを、はるかに良いコスト効率で提供します。

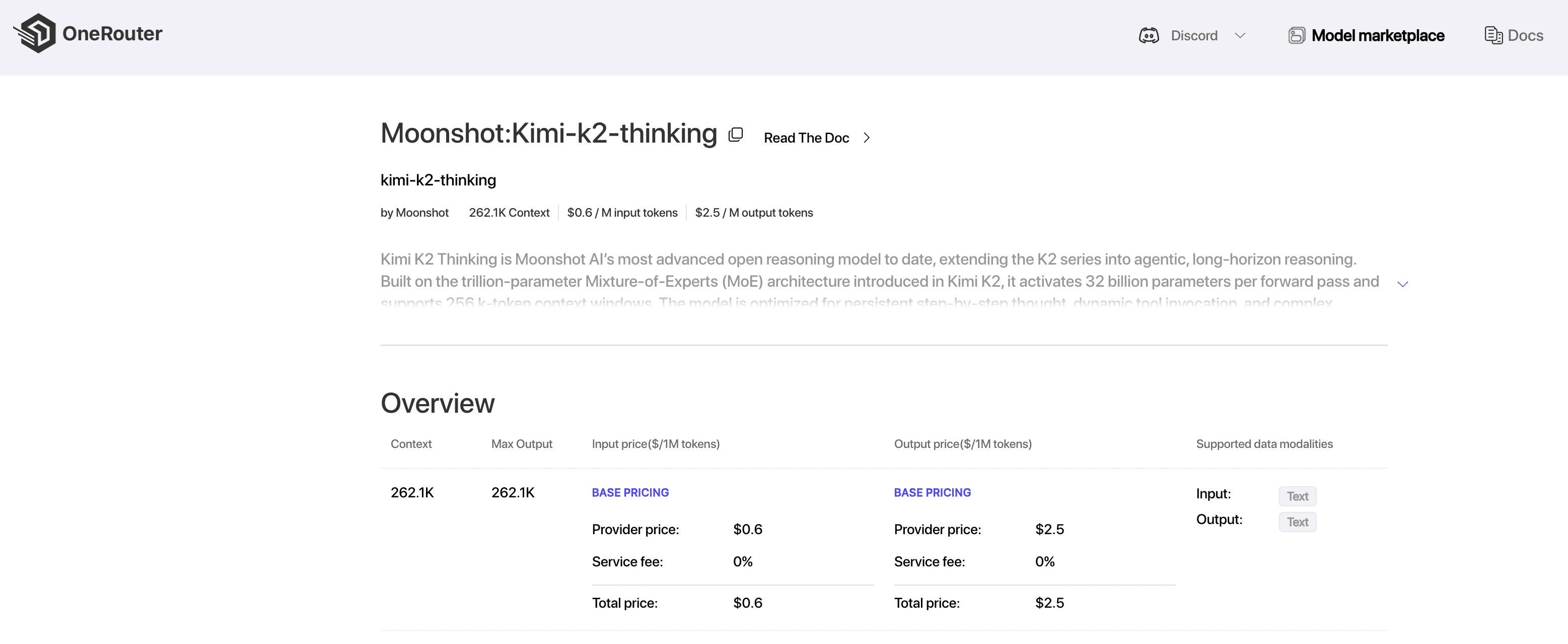

OneRouterは現在、最も手頃なフルコンテキストのKimi-K2-Thinking APIを提供しています。

OneRouterは、262Kコンテキストを持つAPIを提供し、$0.6/入力および$2.5/出力のコストで、構造化された出力と関数呼び出しをサポートし、Kimi K2 Thinkingのコードエージェントの潜在能力を最大限に引き出します。

現在、OneRouterはAnthropic SDK互換のLLM APIサービスを提供しており、Claudeコード内でOneRouter LLMモデルを簡単に利用してタスクを完了できます。統合プロセスを完了するためのガイドは以下をご覧ください。

OneRouterを使用開始する最初のステップは、アカウントを作成することと、APIキーを取得することです。

Claude Codeをインストールする前に、ローカル環境にNode.js 18以上がインストールされていることを確認してください。

Claude Codeをインストールするには、以下のコマンドを実行します:

npm install -g @anthropic-ai/claude-code

ターミナルを開いて、環境変数を以下のように設定します:

# Set the Anthropic SDK compatible API endpoint provided by OneRouter. export ANTHROPIC_BASE_URL="https://llm.onerouter.pro" export ANTHROPIC_AUTH_TOKEN="<OneRouter API Key>" # Set the model provided by OneRouter. export ANTHROPIC_MODEL="kimi-k2-thinking" export ANTHROPIC_SMALL_FAST_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_HAIKU_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_OPUS_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_SONNET_MODEL="kimi-k2-thinking"

次に、プロジェクトディレクトリに移動してClaude Codeを起動します。新しいインタラクティブセッション内でClaude Codeのプロンプトが表示されます:

cd <your-project-directory> claude

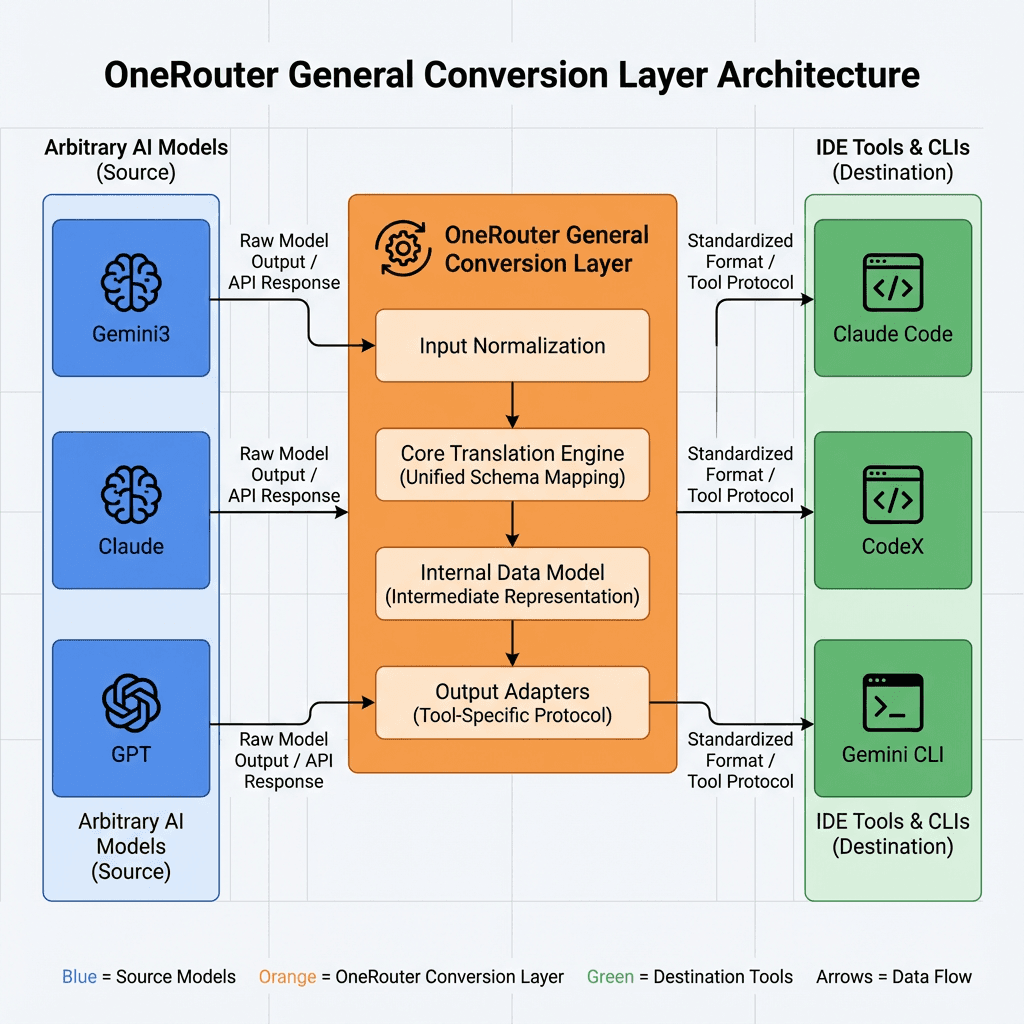

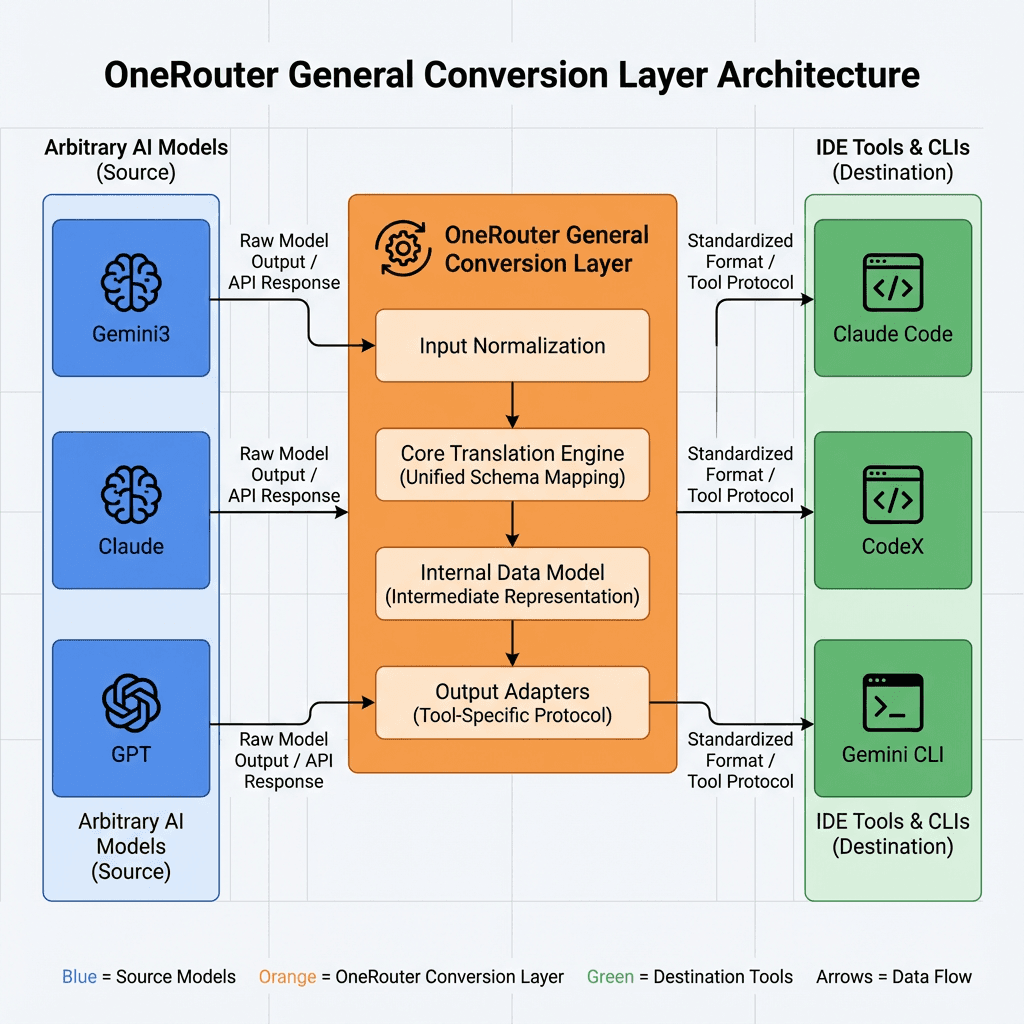

OneRouter一般変換レイヤーを使用すれば、エージェントのロジックを変更することなく、Claude Agent SDKをOneRouter内の任意のモデルで実行できます。

OneRouter一般変換レイヤーにより、開発者は同じSDK APIを使い続けることができます。この変換レイヤーは、提供されたモデル文字列に一致する上流(Anthropic、OpenAI、またはOneRouter内の他のモデル)に対するAnthropicスタイルメッセージリクエストを翻訳します。

Kimi-K2 Thinkingを使用する時期 — タスクの特性と一致する強み

タスクの特徴: 複数のステップのワークフロー、自律的なツール呼び出し、継続的な推論 (例: 研究アシスタント、データマイニングエージェント、オートコーダー)。

Kimi-K2が解決すること: 数百のステップにわたって一貫した推論を維持します;、計画、検索、コーディングを漂うことなく統合します — Kimi-K2では、GPT-5やClaudeが長いシーケンスで焦点を失う場合でも。

タスクの特徴:長いドキュメント、完全なコードベース、または複数のファイル入力を一度に供給する必要があります。

Kimi-K2が解決すること: ネイティブの256Kトークンコンテキストを提供し、フラットな価格設定を行います; 構成なしで膨大な入力を処理しますまたは、ClaudeやGPT-4で見られる高額な長期コンテキスト料金。

タスクの特徴: 大規模なランや厳しい予算(毎日何百万のトークン)。

Kimi-K2が解決すること: 約4〜6倍低コストでClaude/GPTレベルの推論を提供し、スタートアップや持続的なワークロードのために高度な推論を手頃にします。

タスクの特徴: 複雑な推論、構造化されたQA、または、閉じたモデルが支配していた数学的論理。

Kimi-K2が解決すること: AIME、HMMT、およびGPQA DiamondでGPT-5やClaude 4.5を超えるか、これに匹敵するパフォーマンスを発揮します。オープンモデルは、もはや推論が多いドメインでフロンティアレベルのパフォーマンスを発揮できます。

Kimi-K2-Thinkingは、閉じたプロプライエタリシステムとオープンな革新のギャップを埋めます。75〜80%の低コストでClaudeに近いパフォーマンスを提供し、256Kコンテキストウィンドウをサポートし、数百の推論またはツール使用ステップを漂うことなく維持します。深い推論、エージェント的ワークフロー、またはオープンソースの展開を必要とする開発者に対し、Kimi-K2は実用的でスケーラブルで透明なソリューションを提供し、高度なAI推論でコスト効率を再定義します。

Kimi-K2は、200〜300のツール呼び出しにわたって一貫した推論を維持し、最大で5倍のコストがかかりますが、Claude Sonnet 4の価格は長いコンテキストやツールアクションに対して急激に上昇します。

はい。効果的にコードを書くことやデバッグを行えますが、シンプルな単発コーディングよりも、推論が重いか、複数のステップを要するプロジェクトで最も効果を発揮します。

デフォルトで256Kトークンをサポートしており、フルコードベースやドキュメントを一度のパスで推論でき、ClaudeやGPTモデルで見られる長期コンテキストのプレミアム料金なしで処理します。

OneRouterは、単一のエンドポイントを通じて数百のAIモデルへのアクセスを提供する統一APIを提供し、自動的にフォールバックを処理し、最もコスト効果の高いオプションを選択します。お好みのSDKやフレームワークを使用して、数行のコードで始められます。

開発者や研究者は、今日、大規模言語モデルを選択する際に三つの主要な課題に直面しています: 長期的な推論の維持、コンテキスト制限の管理、および運用コストの制御です。Claude Sonnet 4やGPT-5のような従来の閉じたモデルは、強力なパフォーマンスを提供しますが、複数のステップやツールベースのワークフローを扱う際にコストがかさみ、制約を受けます。

この記事では、ステップバイステップの推論、ダイナミックなツール統合、大容量のコンテキストを組み合わせたオープンでエージェント指向の代替手段であるKimi-K2-Thinkingを紹介します。比較、ベンチマーク、セットアップガイドを通じて、Kimi-K2が複雑なAIタスクにおける整合性、スケール、手頃な価格の苦痛をどのように解決するかを説明します。

Kimi-K2 Thinkingは、ステップバイステップのChain-of-Thought推論をダイナミックな関数/ツール呼び出しと交互に行う「思考エージェント」として構築されました。通常のモデルが数回のツール使用後に漂ったり整合性を失ったりするのに対し、Kimi-K2は人間の介入なしで200〜300の連続したツール呼び出しにわたって安定した目標指向の行動を維持します。

これは大きな飛躍です: 以前のオープンモデルは、30〜50ステップ後に劣化する傾向がありました。言い換えれば、Kimi-K2は複雑な問題を解決するために、1セッションで何百もの実行ステップを処理できます。

AnthropicのClaudeは、そのような「交互思考」をツールで知られていましたが、Kimi-K2はこの機能をオープンソースの領域にもたらします。

このアーキテクチャは、スケール、効率、安定性のバランスを取り、Kimi-K2-Thinkingが長いシーケンスにわたって複雑でツールが豊富な推論を維持できるようにします。

アーキテクチャ特徴 | 実用的な利点 |

|---|---|

専門家の混合 (MoE) | コストを上げることなくモデルの能力を拡張し、各タスクに最も関連性の高い専門家を選択します。 |

1Tパラメータ / 32Bアクティブ | 大規模な知識と効率的な計算を組み合わせます。 |

61層と1つの密な層 | ステップ間で深く一貫した推論を維持します。 |

384の専門家、トークンごとに8つがアクティブ | 多様な問題に対する専門性と適応性を向上させます。 |

256Kコンテキスト長 | 非常に長い入力を処理し、長い推論チェーンでの連続性を維持します。 |

MLA (マルチヘッド潜在注意) | 長距離の焦点を強化し、メモリ負荷を軽減します。 |

SwiGLU活性化 | トレーニングを安定させ、滑らかで正確な推論をサポートします。 |

Kimi-K2は、主要な数学ベンチマークでGPT-5やClaudeに近いパフォーマンスを発揮しますが、MMLU-Pro/Redux、Longform WritingおよびCodeではGPT-5やClaudeにわずかに遅れを取っています。

Kimi-K2は、ツールが有効になっている場合や、タスクが長い連鎖的推論を必要とする場合に優れた性能を発揮します (HLE w/ tools = 44.9 vs Claude 32.0)。Kimi-K2は、Claudeのような閉じたモデルとオープンソースシステムの間のギャップを埋め、持続的でツールが豊富な問題解決に優れています。

カテゴリ | ベンチマーク | 設定 | Kimi K2 Thinking | GPT-5 (高) | Claude Sonnet 4.5 (Thinking) | Kimi K2 0905 | DeepSeek-V3.2 | Grok-4 |

|---|---|---|---|---|---|---|---|---|

推論 / 数学 | HLE | ツールなし | 23.9 | 26.3 | 19.8 | 7.9 | 19.8 | 25.4 |

HLE | ツールあり | 44.9 | 41.7 | 32.0 | 21.7 | 20.3 | 41.0 | |

HLE | 重い | 51.0 | 42.0 | – | – | – | 50.7 | |

AIME25 | ツールなし | 94.5 | 94.6 | 87.0 | 51.0 | 89.3 | 91.7 | |

AIME25 | Pythonあり | 99.1 | 99.6 | 100.0 | 75.2 | 58.1 | 98.8 | |

AIME25 | 重い | 100.0 | 100.0 | – | – | – | 100.0 | |

HMMT25 | ツールなし | 89.4 | 93.3 | 74.6 | 38.8 | 83.6 | 90.0 | |

HMMT25 | Pythonあり | 95.1 | 96.7 | 88.8 | 70.4 | 49.5 | 93.9 | |

HMMT25 | 重い | 97.5 | 100.0 | – | – | – | 96.7 | |

IMO-AnswerBench | ツールなし | 78.6 | 76.0 | 65.9 | 45.8 | 76.0 | 73.1 | |

GPQA | ツールなし | 84.5 | 85.7 | 83.4 | 74.2 | 79.9 | 87.5 | |

一般タスク | MMLU-Pro | ツールなし | 84.6 | 87.1 | 87.5 | 81.9 | 85.0 | – |

MMLU-Redux | ツールなし | 94.4 | 95.3 | 95.6 | 92.7 | 93.7 | – | |

Longform Writing | ツールなし | 73.8 | 71.4 | 79.8 | 62.8 | 72.5 | – | |

HealthBench | ツールなし | 58.0 | 67.2 | 44.2 | 43.8 | 46.9 | – | |

エージェント検索 | BrowseComp | ツールあり | 60.2 | 54.9 | 24.1 | 7.4 | 40.1 | – |

BrowseComp-ZH | ツールあり | 62.3 | 63.0 | 42.4 | 22.2 | 47.9 | – | |

Seal-0 | ツールあり | 56.3 | 51.4 | 53.4 | 25.2 | 38.5 | – | |

FinSearchComp-T3 | ツールあり | 47.4 | 48.5 | 44.0 | 10.4 | 27.0 | – | |

Frames | ツールあり | 87.0 | 86.0 | 85.0 | 58.1 | 80.2 | – | |

コーディングタスク | SWE-bench Verified | ツールあり | 71.3 | 74.9 | 77.2 | 69.2 | 67.8 | – |

SWE-bench Multilingual | ツールあり | 61.1 | 55.3 | 68.0 | 55.9 | 57.9 | – | |

Multi-SWE-bench | ツールあり | 41.9 | 39.3 | 44.3 | 33.5 | 30.6 | – | |

SciCode | ツールなし | 44.8 | 42.9 | 44.7 | 30.7 | 37.7 | – | |

LiveCodeBench V6 | ツールなし | 83.1 | 87.0 | 64.0 | 56.1 | 74.1 | – | |

OJ-Bench (cpp) | ツールなし | 48.7 | 56.2 | 30.4 | 25.5 | 38.2 | – | |

Terminal-Bench | シミュレーションツール (JSON) 利用 | 47.1 | 43.8 | 51.0 | 44.5 | – | – |

ツールなし: 純粋な言語推論、外部ツールなし。

ツールあり: 外部ツール (例: 検索、コード) を呼び出すことができます。

Pythonあり: 計算にはPythonのみを使用します。

シミュレーションツール (JSON) 利用: JSON形式でのツール呼び出しをシミュレートします。

重い: 高強度の長鎖推論テスト。

Kimi-K2は、Claude Sonnet 4に対し、約75〜80%低コストで類似の機能を提供します。その価格設定は、長いコンテキスト (最大256Kトークン) や頻繁なツール使用に対しても平坦で、Claudeのコストは長いコンテキストやエージェントアクションに対して急激に上昇します。要するに、Kimi-K2は、複雑で長期的な推論タスクにおいて、Claude/GPTレベルのパフォーマンスを、はるかに良いコスト効率で提供します。

OneRouterは現在、最も手頃なフルコンテキストのKimi-K2-Thinking APIを提供しています。

OneRouterは、262Kコンテキストを持つAPIを提供し、$0.6/入力および$2.5/出力のコストで、構造化された出力と関数呼び出しをサポートし、Kimi K2 Thinkingのコードエージェントの潜在能力を最大限に引き出します。

現在、OneRouterはAnthropic SDK互換のLLM APIサービスを提供しており、Claudeコード内でOneRouter LLMモデルを簡単に利用してタスクを完了できます。統合プロセスを完了するためのガイドは以下をご覧ください。

OneRouterを使用開始する最初のステップは、アカウントを作成することと、APIキーを取得することです。

Claude Codeをインストールする前に、ローカル環境にNode.js 18以上がインストールされていることを確認してください。

Claude Codeをインストールするには、以下のコマンドを実行します:

npm install -g @anthropic-ai/claude-code

ターミナルを開いて、環境変数を以下のように設定します:

# Set the Anthropic SDK compatible API endpoint provided by OneRouter. export ANTHROPIC_BASE_URL="https://llm.onerouter.pro" export ANTHROPIC_AUTH_TOKEN="<OneRouter API Key>" # Set the model provided by OneRouter. export ANTHROPIC_MODEL="kimi-k2-thinking" export ANTHROPIC_SMALL_FAST_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_HAIKU_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_OPUS_MODEL="kimi-k2-thinking" export ANTHROPIC_DEFAULT_SONNET_MODEL="kimi-k2-thinking"

次に、プロジェクトディレクトリに移動してClaude Codeを起動します。新しいインタラクティブセッション内でClaude Codeのプロンプトが表示されます:

cd <your-project-directory> claude

OneRouter一般変換レイヤーを使用すれば、エージェントのロジックを変更することなく、Claude Agent SDKをOneRouter内の任意のモデルで実行できます。

OneRouter一般変換レイヤーにより、開発者は同じSDK APIを使い続けることができます。この変換レイヤーは、提供されたモデル文字列に一致する上流(Anthropic、OpenAI、またはOneRouter内の他のモデル)に対するAnthropicスタイルメッセージリクエストを翻訳します。

Kimi-K2 Thinkingを使用する時期 — タスクの特性と一致する強み

タスクの特徴: 複数のステップのワークフロー、自律的なツール呼び出し、継続的な推論 (例: 研究アシスタント、データマイニングエージェント、オートコーダー)。

Kimi-K2が解決すること: 数百のステップにわたって一貫した推論を維持します;、計画、検索、コーディングを漂うことなく統合します — Kimi-K2では、GPT-5やClaudeが長いシーケンスで焦点を失う場合でも。

タスクの特徴:長いドキュメント、完全なコードベース、または複数のファイル入力を一度に供給する必要があります。

Kimi-K2が解決すること: ネイティブの256Kトークンコンテキストを提供し、フラットな価格設定を行います; 構成なしで膨大な入力を処理しますまたは、ClaudeやGPT-4で見られる高額な長期コンテキスト料金。

タスクの特徴: 大規模なランや厳しい予算(毎日何百万のトークン)。

Kimi-K2が解決すること: 約4〜6倍低コストでClaude/GPTレベルの推論を提供し、スタートアップや持続的なワークロードのために高度な推論を手頃にします。

タスクの特徴: 複雑な推論、構造化されたQA、または、閉じたモデルが支配していた数学的論理。

Kimi-K2が解決すること: AIME、HMMT、およびGPQA DiamondでGPT-5やClaude 4.5を超えるか、これに匹敵するパフォーマンスを発揮します。オープンモデルは、もはや推論が多いドメインでフロンティアレベルのパフォーマンスを発揮できます。

Kimi-K2-Thinkingは、閉じたプロプライエタリシステムとオープンな革新のギャップを埋めます。75〜80%の低コストでClaudeに近いパフォーマンスを提供し、256Kコンテキストウィンドウをサポートし、数百の推論またはツール使用ステップを漂うことなく維持します。深い推論、エージェント的ワークフロー、またはオープンソースの展開を必要とする開発者に対し、Kimi-K2は実用的でスケーラブルで透明なソリューションを提供し、高度なAI推論でコスト効率を再定義します。

Kimi-K2は、200〜300のツール呼び出しにわたって一貫した推論を維持し、最大で5倍のコストがかかりますが、Claude Sonnet 4の価格は長いコンテキストやツールアクションに対して急激に上昇します。

はい。効果的にコードを書くことやデバッグを行えますが、シンプルな単発コーディングよりも、推論が重いか、複数のステップを要するプロジェクトで最も効果を発揮します。

デフォルトで256Kトークンをサポートしており、フルコードベースやドキュメントを一度のパスで推論でき、ClaudeやGPTモデルで見られる長期コンテキストのプレミアム料金なしで処理します。

OneRouterは、単一のエンドポイントを通じて数百のAIモデルへのアクセスを提供する統一APIを提供し、自動的にフォールバックを処理し、最もコスト効果の高いオプションを選択します。お好みのSDKやフレームワークを使用して、数行のコードで始められます。

OneRouterはClaude Codeをサポートしています

By アンドリュー・ジェン •

エンタープライズLLMルーティングの複雑さを管理する

エンタープライズLLMルーティングの複雑さを管理する

AIモデルのトークン使用量を追跡する

AIモデルのトークン使用量を追跡する

OneRouter アンスロポシック クロード API

OneRouter アンスロポシック クロード API