CodexでKimi K2を使用する方法:AIでのコーディングを始める最も速い方法

OneRouterはCodexをサポートしています。

By アンドリュー・ジェン •

OneRouterはCodexをサポートしています。

2025/12/15

アンドリュー・ジェン

Kimi K2 シンキングは、推論駆動の AI における重要な前進を表しています。思考エージェントとして構築され、深い論理的分析と動的なツール使用を組み合わせて、研究、問題解決、コーディング、デバッグといった複雑で多段階のタスクを処理します。Codex に統合されることで、アイデアが実行可能なコードにより早く、より正確に変換されるインテリジェントでインタラクティブなワークフローにコーディングプロセスが変革されます。

このガイドでは、セットアップと構成から最初の AI パワードコーディングセッションまで、Codex における Kimi K2 の使用方法について説明します。これにより、より迅速に始め、より賢くコードを記述できるようになります。

Kimi K2 シンキングは、動的思考エージェントとして構築された Moonshot AI の最新の最先端オープンソース大型言語モデルです。段階的な論理的推論とリアルタイムのツール使用を組み合わせ、推論、コーディング、エージェントのベンチマークにおいて優れた結果を達成し、数百の連続タスクにわたって安定した長期パフォーマンスを維持します。

機能 | 詳細 |

|---|---|

総パラメータ数 | 1T |

トークンごとのアクティブパラメータ | 32B |

総エキスパート数 | 384 |

トークンごとのアクティブエキスパート | 8 (1 共有) |

コンテキスト長 | 256K |

このモデルは、関数呼び出し、ウェブブラウジング、Python 実行、構造化出力生成などのエージェント機能をサポートしています。内部では、MXFP4 ポストトレーニング量子化が効率的な推論を保証します。

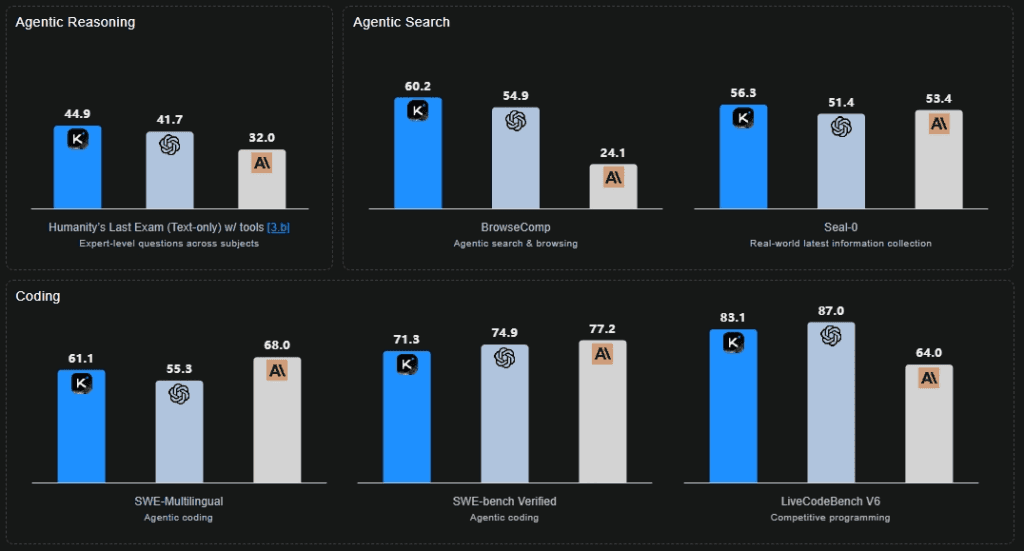

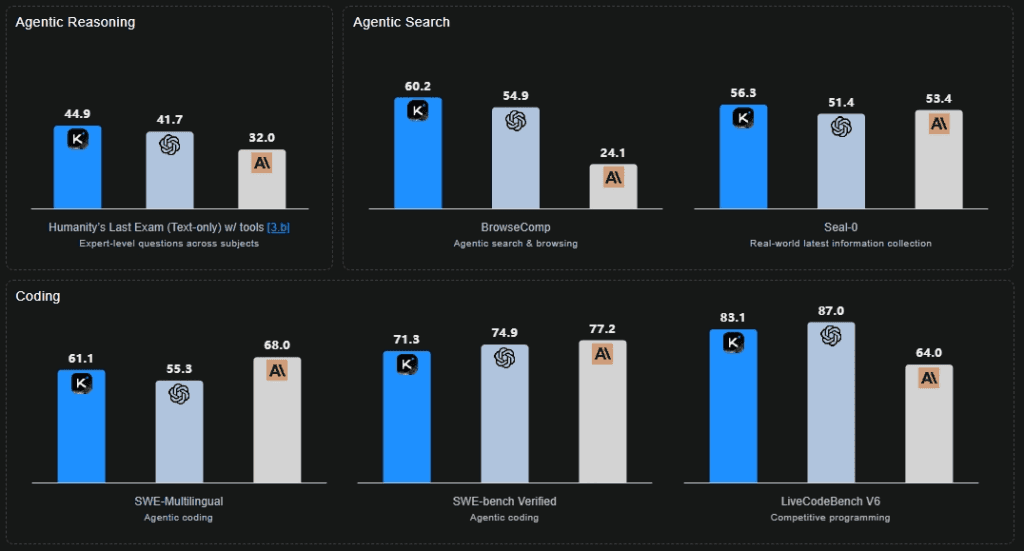

Kimi K2 シンキング vs GPT-5 vs Claude Sonnet 4.5 シンキング

深い推論とツールのオーケストレーション: Kimi K2 シンキングは、構造化された思考の連鎖を動的なツール使用と統合し、研究、分析、コード生成などの複雑で多段階のワークフロー全体にわたり、計画、実行、適応を可能にします。

高度な推論パフォーマンス: 人類最後の試験 (HLE) で最先端の結果を達成し、多段階の論理、問題の分解、オープンエンドな分析的推論で優れた深さを示しています。

優れたコーディングと開発能力: プログラミング言語やフレームワーク間で強い一般化を示し、高い一貫性でコードのリファクタリング、デバッグ、およびマルチファイル生成タスクを効果的に処理します。

エージェントとしての検索とブラウジング機能: BrowseComp およびその他のエージェントベンチマークで優れた性能を発揮し、200〜300 の連続ツール呼び出しを維持しながら、考える → 検索する → 分析する → コードを書くという適応サイクルを実行し、長期的なタスク全体で目標の整合性を維持します。

Kimi K2 シンキングを Codex 環境に統合すると、二つの利点が組み合わさります:Codex のインテリジェントなコーディングサポートと Kimi K2 シンキングの高度な推論能力およびエージェントの能力です。

Codex はいくつかの面で際立っています:

基本的な自動補完を超え、ファイル、依存関係、全体のプロジェクトコンテキストを理解します。

スニペットの補完だけでなく、デバッグ、リファクタリング、テスト生成といった完全なワークフローをサポートします。

ターミナル、IDE、バージョン管理など、開発者のツールチェーンとシームレスに統合され、別のアプリではなく共同開発者として機能します。

Kimi K2 シンキングは、深い推論に基づいたインテリジェントなコーディング環境へと Codex を変えます。ただスニペットを補完するだけでなく、プロジェクトの構造を理解し、編集を計画し、正確に多段階のワークフローを実行します。このモデルは、人間の意図と機械の実行を橋渡しし、開発者がより早く、より賢くコーディングできるようにします。

コンテキストに配慮した理解: 一貫性を維持するために、全体のリポジトリを分析します。

段階的な問題解決: 複雑なプロンプトを論理的なサブタスクに分解し、コーディング前に各ステップを推論します。

反復的なデバッグと洗練: 動的なテスト–検証–修正ループを通じて、論理や構文の問題を検出し解決します。

自律的なワークフロー実行: 長時間のコーディングセッションを安定した推論で処理し、手動での介入やコンテキストのリセットを最小限に抑えます。

Kimi K2 シンキングを Codex 内で使用するには、次の 3 つの準備が必要です:

Kimi K2 シンキング用の API キー: OneRouter から取得することをお勧めします。シームレスな統合のために設定ファイルに保存してください。

Codex CLI: エージェントを直接ターミナルから呼び出せるように、グローバルにインストールされている必要があります。

動作環境: Node.js 18 以上と、パッケージ管理のための npm が必要です。

これらのステップを完了すると、Codex と Kimi K2 シンキングを接続してすぐに探索を開始できるようになります。全体のセットアップは迅速で、数分しかかかりません。

OneRouter アカウントを作成し、OneRouter プラットフォームから API キーを生成します。そして、キー管理に移動し、新しいキーを追加を選択してください。

この API キーはあなたのアクセス認証情報として機能します。一度しか表示されないため、すぐにコピーし、安全に保存することを忘れないでください。次のステップで必要になります。

OneRouter AI は、次のような様々な高度な大型言語モデルのために、最上級の Codex サポートを提供します:

kimi-k2-thinking gpt-oss-120b qwen3-coder-30b-a3b-instruct glm-4.5 deepseek-chat-v3.1

node -v

npm install -g @openai/codex

brew install codex

codex --version

Codex 設定ファイルを作成し、Kimi K2 シンキングをデフォルトモデルとして設定します。

macOS/Linux: ~/.codex/config.toml

macOS/Linux: ~/.codex/config.toml

Windows: %USERPROFILE%\.codex\config.toml

Windows: %USERPROFILE%\.codex\config.toml

基本設定テンプレート

model = "gpt-5.1-chat" model_provider = "onerouter" [model_providers.onerouter] name = "OneRouter" base_url = "https://llm.onerouter.pro/v1" http_headers = {"Authorization" = "Bearer YOUR_ONEROUTER_API_KEY"} wire_api = "chat"

codexコード生成:

> Create a Python class for handling REST API responses with error handling

プロジェクト分析:

> Review this codebase and suggest improvements for performance

バグ修正:

> Fix the authentication error in the login function

テスト:

> Generate comprehensive unit tests for the user service module

Codex CLI を開始する前に、プロジェクトフォルダーに移動します:

cd /path/to/your/project codex

Codex CLI は自動的にプロジェクト構造を検査し、既存のファイルをスキャンし、セッション全体にわたってフルコードベースコンテキストを維持します。

Kimi K2 シンキングは、ステップバイステップで考え、動的にツールを使用し、安定性と精度を持って複雑なコーディングまたは分析タスクを実行するように設計された Moonshot AI の最新のオープンソースモデルです。

Kimi K2 API キーをOneRouterから取得し、Codex 設定でそれを構成し、Kimi K2 をアクティブモデルとして選択して統合を有効にします。

それは、手作業での介入やコンテキストのリセットを減らし、より速く正確なコードの配信を可能にしながら、コードを計画、実行、検証します。

OneRouterは、数百の AI モデルに対し単一のエンドポイントを介してアクセスを提供しつつ、自動でフォールバックを処理し、最もコスト効果の高いオプションを選択します。好みの SDK やフレームワークを使用して、数行のコードで始めることができます。

Kimi K2 シンキングは、推論駆動の AI における重要な前進を表しています。思考エージェントとして構築され、深い論理的分析と動的なツール使用を組み合わせて、研究、問題解決、コーディング、デバッグといった複雑で多段階のタスクを処理します。Codex に統合されることで、アイデアが実行可能なコードにより早く、より正確に変換されるインテリジェントでインタラクティブなワークフローにコーディングプロセスが変革されます。

このガイドでは、セットアップと構成から最初の AI パワードコーディングセッションまで、Codex における Kimi K2 の使用方法について説明します。これにより、より迅速に始め、より賢くコードを記述できるようになります。

Kimi K2 シンキングは、動的思考エージェントとして構築された Moonshot AI の最新の最先端オープンソース大型言語モデルです。段階的な論理的推論とリアルタイムのツール使用を組み合わせ、推論、コーディング、エージェントのベンチマークにおいて優れた結果を達成し、数百の連続タスクにわたって安定した長期パフォーマンスを維持します。

機能 | 詳細 |

|---|---|

総パラメータ数 | 1T |

トークンごとのアクティブパラメータ | 32B |

総エキスパート数 | 384 |

トークンごとのアクティブエキスパート | 8 (1 共有) |

コンテキスト長 | 256K |

このモデルは、関数呼び出し、ウェブブラウジング、Python 実行、構造化出力生成などのエージェント機能をサポートしています。内部では、MXFP4 ポストトレーニング量子化が効率的な推論を保証します。

Kimi K2 シンキング vs GPT-5 vs Claude Sonnet 4.5 シンキング

深い推論とツールのオーケストレーション: Kimi K2 シンキングは、構造化された思考の連鎖を動的なツール使用と統合し、研究、分析、コード生成などの複雑で多段階のワークフロー全体にわたり、計画、実行、適応を可能にします。

高度な推論パフォーマンス: 人類最後の試験 (HLE) で最先端の結果を達成し、多段階の論理、問題の分解、オープンエンドな分析的推論で優れた深さを示しています。

優れたコーディングと開発能力: プログラミング言語やフレームワーク間で強い一般化を示し、高い一貫性でコードのリファクタリング、デバッグ、およびマルチファイル生成タスクを効果的に処理します。

エージェントとしての検索とブラウジング機能: BrowseComp およびその他のエージェントベンチマークで優れた性能を発揮し、200〜300 の連続ツール呼び出しを維持しながら、考える → 検索する → 分析する → コードを書くという適応サイクルを実行し、長期的なタスク全体で目標の整合性を維持します。

Kimi K2 シンキングを Codex 環境に統合すると、二つの利点が組み合わさります:Codex のインテリジェントなコーディングサポートと Kimi K2 シンキングの高度な推論能力およびエージェントの能力です。

Codex はいくつかの面で際立っています:

基本的な自動補完を超え、ファイル、依存関係、全体のプロジェクトコンテキストを理解します。

スニペットの補完だけでなく、デバッグ、リファクタリング、テスト生成といった完全なワークフローをサポートします。

ターミナル、IDE、バージョン管理など、開発者のツールチェーンとシームレスに統合され、別のアプリではなく共同開発者として機能します。

Kimi K2 シンキングは、深い推論に基づいたインテリジェントなコーディング環境へと Codex を変えます。ただスニペットを補完するだけでなく、プロジェクトの構造を理解し、編集を計画し、正確に多段階のワークフローを実行します。このモデルは、人間の意図と機械の実行を橋渡しし、開発者がより早く、より賢くコーディングできるようにします。

コンテキストに配慮した理解: 一貫性を維持するために、全体のリポジトリを分析します。

段階的な問題解決: 複雑なプロンプトを論理的なサブタスクに分解し、コーディング前に各ステップを推論します。

反復的なデバッグと洗練: 動的なテスト–検証–修正ループを通じて、論理や構文の問題を検出し解決します。

自律的なワークフロー実行: 長時間のコーディングセッションを安定した推論で処理し、手動での介入やコンテキストのリセットを最小限に抑えます。

Kimi K2 シンキングを Codex 内で使用するには、次の 3 つの準備が必要です:

Kimi K2 シンキング用の API キー: OneRouter から取得することをお勧めします。シームレスな統合のために設定ファイルに保存してください。

Codex CLI: エージェントを直接ターミナルから呼び出せるように、グローバルにインストールされている必要があります。

動作環境: Node.js 18 以上と、パッケージ管理のための npm が必要です。

これらのステップを完了すると、Codex と Kimi K2 シンキングを接続してすぐに探索を開始できるようになります。全体のセットアップは迅速で、数分しかかかりません。

OneRouter アカウントを作成し、OneRouter プラットフォームから API キーを生成します。そして、キー管理に移動し、新しいキーを追加を選択してください。

この API キーはあなたのアクセス認証情報として機能します。一度しか表示されないため、すぐにコピーし、安全に保存することを忘れないでください。次のステップで必要になります。

OneRouter AI は、次のような様々な高度な大型言語モデルのために、最上級の Codex サポートを提供します:

kimi-k2-thinking gpt-oss-120b qwen3-coder-30b-a3b-instruct glm-4.5 deepseek-chat-v3.1

node -v

npm install -g @openai/codex

brew install codex

codex --version

Codex 設定ファイルを作成し、Kimi K2 シンキングをデフォルトモデルとして設定します。

macOS/Linux: ~/.codex/config.toml

macOS/Linux: ~/.codex/config.toml

Windows: %USERPROFILE%\.codex\config.toml

Windows: %USERPROFILE%\.codex\config.toml

基本設定テンプレート

model = "gpt-5.1-chat" model_provider = "onerouter" [model_providers.onerouter] name = "OneRouter" base_url = "https://llm.onerouter.pro/v1" http_headers = {"Authorization" = "Bearer YOUR_ONEROUTER_API_KEY"} wire_api = "chat"

codexコード生成:

> Create a Python class for handling REST API responses with error handling

プロジェクト分析:

> Review this codebase and suggest improvements for performance

バグ修正:

> Fix the authentication error in the login function

テスト:

> Generate comprehensive unit tests for the user service module

Codex CLI を開始する前に、プロジェクトフォルダーに移動します:

cd /path/to/your/project codex

Codex CLI は自動的にプロジェクト構造を検査し、既存のファイルをスキャンし、セッション全体にわたってフルコードベースコンテキストを維持します。

Kimi K2 シンキングは、ステップバイステップで考え、動的にツールを使用し、安定性と精度を持って複雑なコーディングまたは分析タスクを実行するように設計された Moonshot AI の最新のオープンソースモデルです。

Kimi K2 API キーをOneRouterから取得し、Codex 設定でそれを構成し、Kimi K2 をアクティブモデルとして選択して統合を有効にします。

それは、手作業での介入やコンテキストのリセットを減らし、より速く正確なコードの配信を可能にしながら、コードを計画、実行、検証します。

OneRouterは、数百の AI モデルに対し単一のエンドポイントを介してアクセスを提供しつつ、自動でフォールバックを処理し、最もコスト効果の高いオプションを選択します。好みの SDK やフレームワークを使用して、数行のコードで始めることができます。

OneRouterはCodexをサポートしています。

By アンドリュー・ジェン •

エンタープライズLLMルーティングの複雑さを管理する

エンタープライズLLMルーティングの複雑さを管理する

AIモデルのトークン使用量を追跡する

AIモデルのトークン使用量を追跡する

OneRouter アンスロポシック クロード API

OneRouter アンスロポシック クロード API